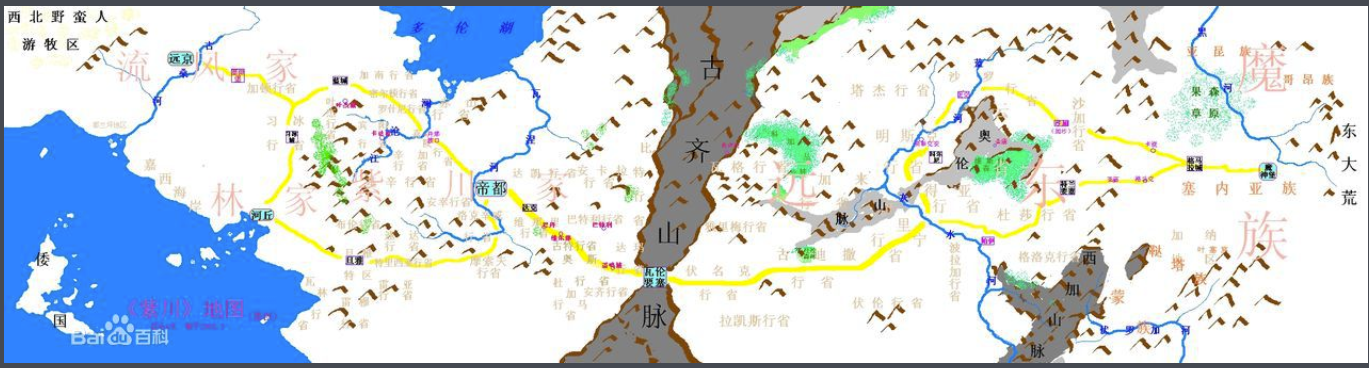

读书感悟-《紫川》

最近事情太多,压力有点大,想找本书看看逃避一下,于是就搜到了这本书<紫川>。

我不是那种揪细节的人,所以总的感觉这本书还是非常不错的,基本所有坑都被填上了。

大约花了5天时间看完吧,感觉好久没读书了,阅读速度太慢。合上书本搜索下脑海中的记忆。

工具使用-hexo 主题中部分数学公式无法正确显示的解决办法

在用hexo+github搭建的技术博客中,虽然开启了mathjax,但是在显示网页内容时,有的公式能够正常显示,有个公式却显示不了,这是因为默认的公式渲染会出现问题, 有些markdown符号会被转成html标签导致错误。所以需要做一定的设置和修改。参见下述链接,修改成功。

阅读笔记-Online Multi-Object Tracking with Instance-Aware Tracker and Dynamic Model Refreshment

首先祝各位儿童节快乐。

![]()

这篇文章看标题就能大概知道主要的内容有两点,一个instance-aware是说每个目标作为单独的instance考虑,同时每个instance的模型需要在线的动态更新。

深度学习-nms 和 softnms [代码]

NMS ( Non-Maximum Suppression), 非极大值抑制算法,在目标检测领域内非常常见。而SoftNMS是针对于NMS提出的进一步改进。本文主要阐述NMS和SoftNMS算法并分享其代码实现。

深度学习-检测器的评价指标 mAP [代码]

对于大多数利用机器学习方法求解的问题来说一般都会存在多个可用模型。 每一个模型都有自己的特点,从而在不同的因素作用下,其表现性能也会出现差异。

模型的性能一般通过其在某个数据集上的表现来评价, 一般这个数据集是对应于训练集的“验证集”或者“测试集”。 性能的定量评价可以有多重指标,比如 acc, pre和recall等。具体选择哪一种指标取决于具体应用和场景。而对于同一种应用,找到一个能够公正合理的比较不同模型的指标则非常重要。

这篇文章我们将会讲一讲目标检测问题中最常见的评价指标 mAP, (The Mean Average Precision)

原文:Measuring Object Detection models - mAP - What is Mean Average Precision?

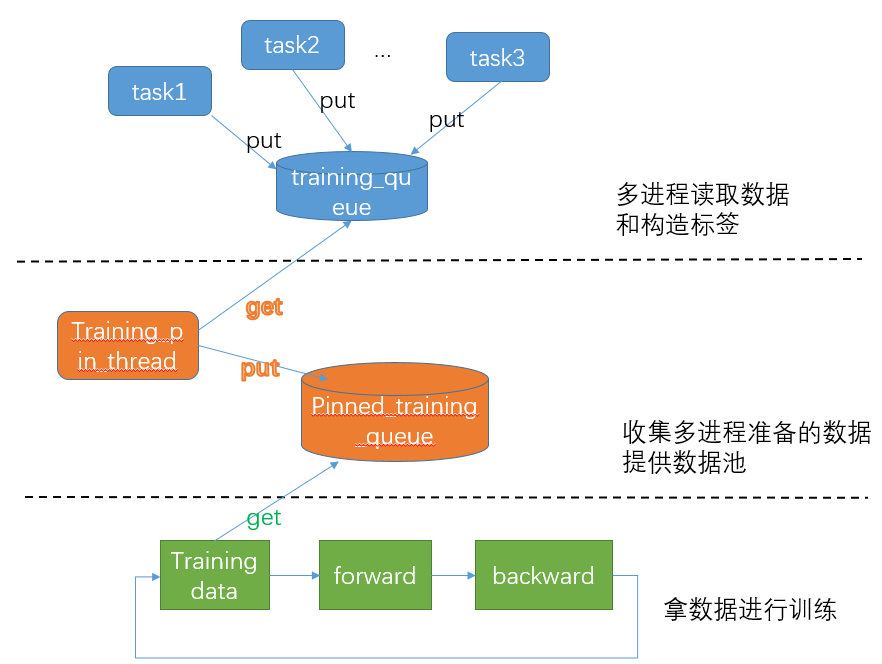

深度学习-Normalization layers

Normalization 层主要解决的问题是希望输入数据能大致分布在相同的空间内,从而让训练更好更快的收敛。 最先提出的Batch normalization 层对于深度网络的收敛起到了很大的促进作用,于是后续又有多种normalization层提出,这里总结下normlization的相关知识。

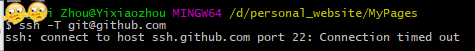

工具使用-Windows系统下使用git出现connection timed out解决方案

Windows 下使用git的默认通信端口是22,但有时候22因为防火墙等原因会通信失败这时候会出现下述状况。

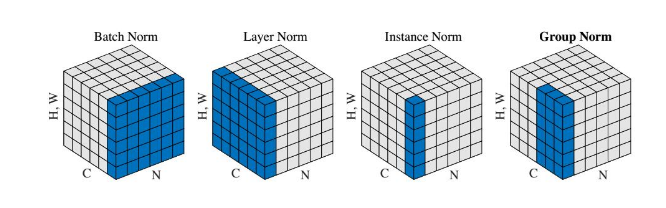

代码片段-pytorch加载预训练模型的部分参数和设置不同的学习率

随着数据集越来越大,像ImageNet, COCO这种量级的数据大公司动辄上百张的GPU一起训练可能时间还不算啥,但对于大多数人来说,计算资源还是非常紧张的,所以最好的策略应该就是使用预训练的权重参数在自己的数据上进行微调。 而任务和数据的不同,导致我们的模型一定会做出相应的修改。如何从预训练的权重参数中抽取部分曾参数初始化我们自己的模型,以及如何给不同层设置学习率是这篇笔记的重点。